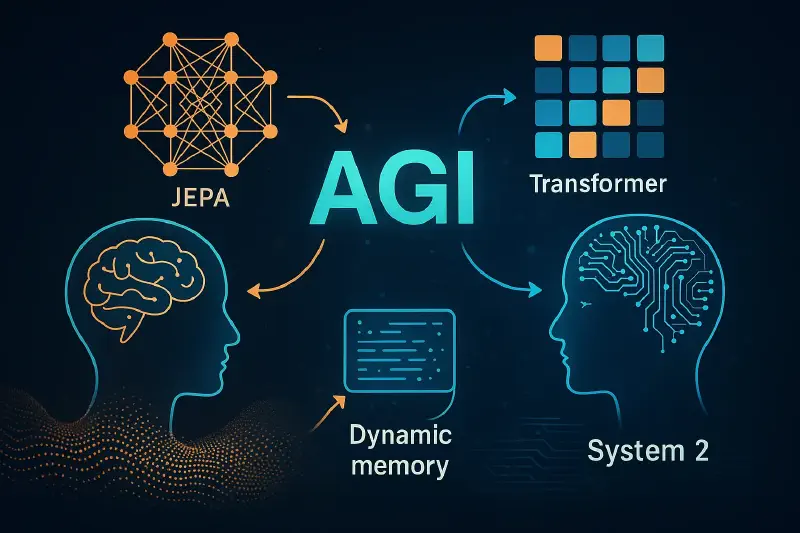

最近在NVIDIA GTC 2025举办的“AI与计算前沿”主题讨论中,AI领域的先驱Yann LeCun与Bill Dally的对话激发了我对通用人工智能(AGI)未来的深入探索。讨论内容涵盖了深度学习的新兴趋势、AI架构的演进以及创新硬件的关键作用。受此启发,我再次回顾了一个基础的认知框架:Daniel Kahneman著名的“系统1”与“系统2”。

超越系统1与系统2的二元对立

Kahneman将人类思维分为两种截然不同的模式:

- 系统1:快速、自动、直觉式。

- 系统2:缓慢、深思熟虑、分析性。

然而,随着思考的深入,我愈发清楚地意识到,我们的思维并不能简单地被这两个盒子所归类。实际上,它更像是一个连续体——可以想象成平滑的渐变,而非二元的开关。在低端,是纯粹的潜意识反射过程;在高端,则是深刻的反思与哲学思考。这个洞见让我思考:我们的AI模型,为什么不能也反映这种连续的认知光谱呢?

用JEPA可视化抽象思维

为了更好地理解这种渐变,不妨考虑一下我们如何可视化复杂的物体。人类能够轻松地将原始感官数据——比如来自双眼的两幅略有不同的图像——转化为生动的三维心理图像。随后,我们从这个心理模型中抽象出有意义的细节,并将这些洞见传递到更为深思熟虑、分析性的思维过程之中。

这一认识让我关注到Yann LeCun提出的JEPA(联合嵌入预测架构)。JEPA天生擅长建模预测性认知,类似于我们的直觉“系统1”。它以一种非常接近人类直觉的方式预测缺失信息。最初,将JEPA与如GPT这样的Transformer模型结合似乎是自然而然的选择。虽然Transformers在逐步生成连贯语言方面表现出色,但却缺乏JEPA的预测抽象能力。那么,能否将两者结合,构建更丰富的认知架构?

集成注意力:融合Transformers与JEPA

但在实际中,如何整合这两种模型?与其将JEPA和Transformer视为并行的两条流,不如直接将JEPA嵌入到Transformer的潜在空间中。可以将注意力机制想象成信息的“守门员”,动态决定:

- 何时利用JEPA的预测洞见(将JEPA视为直觉的“本能反应”)。

- 何时完全依赖Transformer逐字逐句的详细生成。

这个想法可以类比为一个心理“总机”,根据上下文不断调整直觉与逻辑之间的平衡。这种动态灵活性,正如人类在快速判断与深思熟虑之间自如切换。

快照学习:随时间捕捉知识

在进一步探索中,我想象了一种类似人类记忆的场景——通过“快照”进行学习。与其无休止地微调一个庞大的模型,不如每隔一段时间(例如每训练1000万token)捕捉一次“知识快照”。每个快照都新增一层轻量级的结构,类似于LoRA(低秩适应),层层叠加。

这种方法有一个形象的类比:想象地质中的沉积层,每一层都代表某一时期获得的知识。较老的层逐渐变得不那么相关,最终被压缩或丢弃,从而保持高效。

扩展维度以实现动态知识管理

我将这个概念进一步拓展,提出在潜在空间中增加第三个维度——本质上是垂直堆叠知识层。每一次训练都在这个维度上新增一个“知识层”。模型在做出预测时,会沿着这个新轴将各层知识聚合起来,形成统一的理解。

但这也带来了一个重要问题:维度的增加意味着模型体积急剧膨胀,计算压力巨大。我的解决方案是:定期进行剪枝或合并,将较旧、作用较小的知识层压缩成紧凑的形式,从而在保留知识的同时兼顾效率。

处理模型的不确定性

我还深入思考了不确定性——这是人类思维的固有特征。目前的语言模型即使不确定也会强行给出答案。为什么不直接编码不确定性呢?想象训练模型在遇到不确定时输出一个特殊token(比如“我不确定”)。这个token可以提示模型暂停,并重新调用JEPA的广泛预测能力,就像人类会退一步重新思考一样。

动态遗忘与持续学习

我的最后一个洞见聚焦于动态管理知识,模拟人类记忆的灵活性。人类会自然地遗忘过时的信息,而AI模型目前还做不到。我们能否实现一种“负LoRA”机制——主动剪除过时参数?

这种方法类似于“弹性权重固化”,即关键参数保持不变,而不重要的参数被剪枝或更新。定期评估知识的相关性,确保模型既能保持最新状态,又能控制计算资源消耗。

总结与开放性问题

回顾这次探索,我的结论很明确:

- 我们不应将系统1和系统2割裂开来,而应构建一个统一、集成的认知系统,无缝融合直觉与分析处理。

- 我们需要动态机制,实现持续学习与选择性遗忘,模拟自然的认知灵活性。

但仍有许多问题待解:

- 如何管理多维潜在空间带来的计算复杂度?

- 动态剪枝能否真正让模型保持高效?

- 集成注意力机制能否真实模拟直觉与分析之间的无缝切换?

这些问题将指引我未来的探索。归根结底,理解并模拟人类认知,要求我们超越传统的二元对立,拥抱流动、动态的相互作用——这是我渴望继续深入的方向。